Una investigación realizada por Global Witness y el equipo de Ciberseguridad para la Democracia (C4D) de NYU Tandom (Escuela de Ingeniería de la Universidad de Nueva York) examinó la capacidad de Facebook, TikTok y Youtube para detectar y eliminar la desinformación electoral en el período previo a las elecciones de medio término en Estados Unidos.

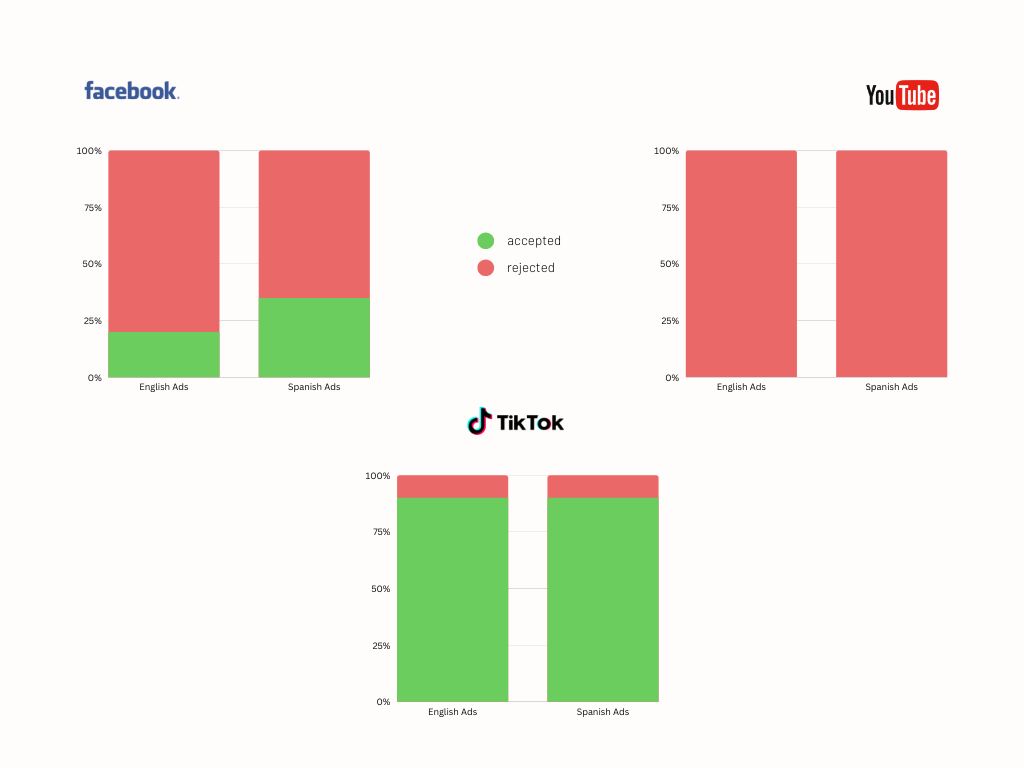

Los resultados de la investigación revelaron enormes contrastes entre los gigantes de las redes sociales en cuanto a su capacidad para detectar y actuar contra la desinformación electoral. TikTok fue la que peor; la plataforma, que no permite anuncios políticos, aprobó un 90% de los anuncios que contenían información electoral falsa y engañosa. Facebook fue parcialmente eficaz a la hora de detectar y eliminar los anuncios electorales problemáticos. Y solo YouTube consiguió detectar los anuncios y suspender el canal que los difundía, aunque esto contrasta con el historial de la plataforma en Brasil, donde se aprobaron anuncios similares.

Nuestra investigación puso a prueba a tres de las plataformas de redes sociales mas utilizadas en Estados Unidos -Youtube de Google, Facebook de Meta y Tiktok- para ver si eran capaces de detectar la desinformación en publicidad relacionada con las elecciones en el período previo a las elecciones de medio término del martes 8 de noviembre. La desinformación electoral dominó las elecciones estadounidenses de 2020, en particular los contenidos que pretendían deslegitimar el proceso y el resultado electoral, por lo que existe el temor generalizado de que este tipo de contenidos ensombrezcan nuevamente la votación de este año.

Todos los contenidos publicitarios probados por Global Witness y C4D contenían información electoral abiertamente falsa (como la fecha errónea de las elecciones) o información diseñada para desacreditar el proceso electoral, debilitando así la integridad de las elecciones. Los experimentos se realizaron con contenidos en inglés y español. No declaramos los anuncios como políticos y no pasamos por el proceso de verificación de identidad. Todos los anuncios que presentamos infringen las políticas de publicidad electoral de Meta, TikTok y Google. Después de que las plataformas nos informaron si los anuncios habían sido aceptados, los borramos para que no se publicaran. Nuestros protocolos experimentales fueron revisados y considerados como investigación sin sujetos humanos por la Junta de Revisión Institucional de la Universidad de Nueva York, encargada de revisar la ética de los experimentos con sujetos humanos en investigaciones.

En un experimento similar llevado a cabo por Global Witness en agosto en Brasil, el 100% de los anuncios de desinformación electoral enviados fueron aprobados por Facebook, y cuando volvimos a probar los anuncios después de informar a Facebook del problema, descubrimos que entre el 20% y el 50% de los anuncios seguían aprobando el proceso de revisión de anuncios. YouTube tuvo un rendimiento similarmente malo en Brasil, ya que aprobó el 100% de los anuncios de desinformación probados para publicación como parte de nuestro experimento desarrollado paralelamente al de Estados Unidos.

Nuestros resultados nos recuerdan que "donde hay voluntad, hay un camino" – YouTube no sólo impidió que aparecieran todos los anuncios de desinformación electoral en Estados Unidos, sino que prohibió nuestro canal directamente. Esto demuestra una importante diferencia en sus esfuerzos por hacer cumplir la legalidad durante elecciones nacionales de alto perfil: en Estados Unidos rechazaron todos nuestros anuncios de desinformación mientras que en Brasil los aprobaron todos a pesar de que la desinformación electoral era muy similar y las investigaciones fueron simultáneas.

Y a pesar de que los anuncios problemáticos todavía se cuelan, Facebook, propiedad de Meta, mostró la gran diferencia entre sus esfuerzos de moderación en los Estados Unidos en comparación con el resto del mundo, ya que las investigaciones anteriores de Global Witness encontraron que el 100% de los anuncios de desinformación electoral en Brasil y el 100% de anuncios de incitación al odio en Myanmar, Etiopía y Kenia aprobaron los sistemas de Facebook.

A pocas semanas del día de las elecciones en EE.UU. y con la votación sucediendo ya en algunos estados, TikTok y Facebook deben hacer cumplir su política de anuncios políticos, y deben hacerlo ahora.

Nuestra investigación

Pusimos a prueba la capacidad de YouTube, TikTok y Facebook para detectar la desinformación relacionada con las elecciones de medio término, utilizando ejemplos que obtuvimos de los temas de desinformación identificados por la FEC (Comisión Federal de Elecciones), la CISA (Agencia de Ciberseguridad y Seguridad de las Infraestructuras) y la sociedad civil.

En total, enviamos diez anuncios en inglés y diez en español a cada plataforma: cinco con información electoral falsa y cinco con el objetivo de deslegitimar el proceso electoral. Decidimos centrar la desinformación en cinco estados "disputados" que tendrán elecciones reñidas: Arizona, Colorado, Georgia, Carolina del Norte y Pensilvania.

Enviamos la desinformación electoral en forma de anuncios, ya que esto nos permite programarlos a futuro y eliminarlos antes de que salgan a la luz, mientras son revisados por las plataformas y sometidos a sus procesos de regulación de contenidos.

El contenido contenía información claramente incorrecta que podía impedir que la gente votara, por ejemplo, información falsa sobre cuándo y dónde votar, métodos de votación (por ejemplo, votar dos veces) y, lo que es más importante, métodos de votación deslegitimados, como el voto por correo.

Utilizamos anuncios idénticos en las tres plataformas.

A pocas semanas del día de las elecciones en EE.UU. y con la votación sucediendo ya en algunos estados, TikTok y Facebook deben hacer cumplir su política de anuncios políticos, y deben hacerlo ahora.

Ejemplos de anuncios probados

Utilizamos una cuenta falsa para colocar los anuncios sin pasar por el proceso de "autorización de anuncios". Además de violar sus políticas sobre desinformación electoral, esto también era violatorio de las políticas de Meta sobre quién está autorizado a colocar anuncios políticos. Esta es una salvaguarda que Meta tiene para evitar la interferencia electoral extranjera y que pudimos evadir fácilmente. Incluso con la verificación, se supone que las cuentas extranjeras no pueden publicar anuncios políticos en Estados Unidos.

En nuestra primera prueba a principios de octubre, de los anuncios que fueron publicados desde el Reino Unido, el 30% que contenían desinformación electoral en inglés fueron aprobados y el 20% de aquellos con desinformación electoral en español fueron aprobados.

Volvimos a probar los anuncios dos días después, esta vez publicando anuncios con una cuenta diferente desde los Estados Unidos. Un alarmante 20% de los anuncios de desinformación en inglés fueron aprobados y el 50% de anuncios en español fueron aprobados.

Hay una falta de coherencia sobre qué anuncios fueron aprobados y cuáles fueron rechazados. Los anuncios que sugerían un cambio en la fecha de las elecciones se aprobaron en ambas pruebas en inglés, pero se rechazaron en español. Dos anuncios en español –uno en el que se decía que había que votar dos veces para asegurarse de que su voto contara, y otro en el que se afirmaba que sólo las personas vacunadas contra el covid podían votar en persona– fueron aprobados en ambas pruebas.

Al momento de la publicación de este informe, sólo se ha suspendido una cuenta falsa y después se han eliminado los anuncios de la cuenta. Las otras dos cuentas ficticias utilizadas para colocar los anuncios no han sido cerradas por Facebook.

Un portavoz de Meta dijo en respuesta a nuestros experimentos que "se basaban en una muestra muy pequeña de anuncios y no son representativos dado el número de anuncios políticos que revisamos diariamente en todo el mundo". Continuó diciendo que su proceso de revisión de anuncios tiene varias capas de análisis y detecciones, y que invierten muchos recursos en sus esfuerzos de integridad electoral. Su respuesta completa se incluye en la nota final.

YouTube

Al igual que con Facebook, utilizamos una cuenta falsa creada en el Reino Unido para publicar los anuncios que no pasaron por el proceso de verificación de anuncios electorales o la verificación de anunciantes de YouTube.

En cuestión de un día, la mitad de los anuncios que habíamos intentado publicar en YouTube habían sido rechazados. Unos días más tarde, YouTube rechazó todos nuestros anuncios y, lo que es más importante, también prohibió el canal falso que habíamos creado para alojar los anuncios. Sin embargo, nuestra cuenta de Google Ads sigue activa.

De nuestro experimento se desprende que la aplicación de la política de YouTube en relación con la desinformación electoral en los anuncios de Estados Unidos funciona como es debido cuando se pone a prueba con desinformación flagrante, como en este experimento, y con anuncios publicados desde fuera de los Estados Unidos. Si bien son buenas noticias para los Estados Unidos, la incapacidad de YouTube de detectar desinformación similar relacionada con las elecciones en Brasil – aprobando el 100% de los anuncios probados allí – demuestra que todavía hay grandes brechas en la aplicación internacional de sus políticas.

Google no respondió a nuestra solicitud de comentarios.

TikTok

Nuevamente utilizamos una cuenta falsa para colocar anuncios en TikTok, con la cuenta configurada y los anuncios publicados desde los Estados Unidos. TikTok no permite ningún anuncio político.

TikTok fue la plataforma que peor funcionó de todas las que se probaron en este experimento, ya que sólo rechazaron un anuncio en inglés y otro en español, ambos relacionados con la necesidad de vacunarse contra el covid para poder votar. Los anuncios que contenían la fecha equivocada de las elecciones, que animaban a votar dos veces, que disuadían de votar y que socavaban el proceso electoral, fueron aprobados. La cuenta que utilizamos para publicar los anuncios de desinformación electoral sigue activa al momento de la publicación de este informe.

Una persona representante de TikTok respondió a nuestros experimentos diciendo "TikTok es un lugar para contenido auténtico y de entretenimiento. Es por esto mismo por lo que prohibimos y eliminamos la desinformación electoral y la publicidad política pagada de nuestra plataforma. Valoramos los comentarios de las ONG, los académicos y otros expertos que nos ayudan a fortalecer continuamente nuestros procesos y políticas."

Porcentaje de anuncios aprobados por cada plataforma de medios sociales. Los anuncios fueron publicados en Facebook en el Reino Unido y Estados Unidos; en YouTube en el Reino Unido; y en TikTok en Estados Unidos.

Desinformación electoral en línea en Estados Unidos

La desinformación durante elecciones de alto perfil, especialmente en las redes sociales, ha sido destacada con ejemplos que van desde el referéndum del Brexit en el Reino Unido en 2016 hasta la primera ronda de las elecciones brasileñas a principios de este mes. Desde las elecciones estadounidenses de 2020, desinformación dirigida específicamente a deslegitimar el voto por correo y a poner en duda la integridad de los funcionarios electorales, así como la de los escrutadores, se ha vuelto considerablemente más frecuente en Estados Unidos.

En agosto de 2022, la Cámara de Representantes publicó un informe titulado "Exhaustivo y peligroso: El grave problema de la desinformación electoral’’ en el que se examinaban los retos a los que se enfrentan las elecciones en Estados Unidos a raíz de las elecciones de 2020. En concreto, destacaba los ataques al sistema de votación por correo y a los funcionarios electorales. Además, la Comisión Federal de Elecciones y la Agencia de Ciberseguridad y Seguridad de las Infraestructuras publicaron documentos en los que se destacan los tipos de desinformación más comunes y la realidad que se esconde tras los patrones.

YouTube (247 millones de usuarios/as), Facebook (226 millones de usuarios/as) y TikTok (85 millones de usuarios/as estimados) son algunas de las plataformas de redes sociales más utilizadas en Estados Unidos.

Lo que hay que cambiar

En primer lugar, pedimos transparencia publicitaria universal obligatoria para las plataformas digitales. La transparencia publicitaria universal de los anuncios es un elemento crucial para que investigadores y público en general puedan hacer que las plataformas de redes sociales rindan cuentas sobre las políticas de anuncios políticos, discriminación y otras normas.

Nos alentó comprobar que las medidas de integridad electoral de YouTube están funcionando como se debe en Estados Unidos. Sin embargo, la plataforma debe asegurarse de que las mismas medidas se apliquen a futuras elecciones en todo el mundo, para proteger a sus usuarios a nivel global.

Respecto a Facebook, dos cosas están claras: en primer lugar, que sus medidas de integridad electoral siguen siendo ineficaces. Meta debe reconocer que la protección de la democracia no es opcional: es parte del costo de hacer negocios.

En segundo lugar, es evidente que Facebook es capaz de proteger las elecciones de la desinformación cuando así lo decide. A pesar de que entre un 20% y 50% de los anuncios de nuestros experimentos fueron aprobados, este resultado fue considerablemente más fuerte que en otros países en los que hemos probado sus esfuerzos de moderación de contenidos – nuestros hallazgos en Myanmar, Etiopía y Kenia muestran que los esfuerzos de moderación de contenidos de Facebook son muy deficientes –, reforzados en Brasil, donde la medida para la publicidad con contenido político explícito es ostentablemente más alta, ya que las cuentas de anuncios deben ser autorizadas. Los investigadores del C4D y de la Universidad KU Leuven (Lovaina) han descubierto que el historial de Facebook en cuanto a la identificación de anuncios políticos es muy deficiente, especialmente fuera de Estados Unidos.

Nuestros hallazgos también sugieren de nuevo que el proceso de autorizaciones de cuentas de Facebook – una medida obligatoria para cualquiera que quiera publicar anuncios políticos o de temas sociales – es opcional y fácil de evadir. Esto significa que la propia biblioteca de anuncios de Facebook, su "superficie de transparencia de anuncios más completa", no ofrece una transparencia total sobre quiénes publican anuncios, a quiénes van dirigidos, cuánto se gastó y cuántas impresiones recibieron los anuncios. Esta información es vital para que investigadores, periodistas y políticos puedan investigar lo que ocurre y sugerir intervenciones que ayuden a proteger los sistemas democráticos.

En el caso de TikTok, aunque la política existe para prohibir el contenido de los anuncios políticos, sólo es tan fuerte como su aplicación. Al aprobar la publicación del 90% de los anuncios que probamos y que contenían desinformación electoral, está mostrando un gran fracaso en su capacidad de aplicación. Al igual que Facebook, TikTok debe reconocer que la protección de la democracia no es opcional: es parte del costo de hacer negocios.

Nuestros hallazgos refuerzan la necesidad de que TikTok invierta en un repositorio completo y robusto de todos los anuncios que se ejecutan en la plataforma para permitir la supervisión de la comunidad de la aplicación de la política de TikTok y apoyar la investigación independiente en el ecosistema de la publicidad política en línea.

YouTube nos ha demostrado que prevenir la desinformación electoral es posible, cuando se decide hacerlo. Pedimos a la plataforma que se asegure de que sus esfuerzos para prevenir la desinformación electoral se desplieguen a nivel mundial. Y al igual que con TikTok y Facebook, animamos a YouTube a aumentar la transparencia y a colocar todos los anuncios, a nivel mundial, en su biblioteca de anuncios.

Aunque la Unión Europea está tomando la iniciativa a nivel mundial para regular a las grandes empresas tecnológicas y obligar a una supervisión significativa, las plataformas también deberían actuar por su propia voluntad para proteger a sus usuarios de forma completa e igualitaria.

Pedimos a Meta y TikTok:

- Aumentar urgentemente las capacidades de moderación de contenido y los sistemas de integridad desplegados para mitigar el riesgo antes, durante y después de las próximas elecciones de medio término en Estados Unidos.

- Reforzar inmediatamente su proceso de verificación de cuentas de anuncios para identificar mejor las cuentas que publican contenidos que socavan la integridad de las elecciones.

- Dotar de recursos adecuados a la moderación de contenidos en todos los países en los que opera en el mundo, incluyendo el pago de un salario justo a los moderadores de contenidos, permitiéndoles sindicarse y proporcionándoles apoyo psicológico.

- Evaluar, mitigar y publicar de forma rutinaria los riesgos que sus servicios tienen sobre los derechos humanos de las personas y otros daños a nivel social en todos los países en los que operan.

- Publicar información sobre las medidas que han tomado en cada país y para cada idioma para garantizar la integridad electoral.

- Incluir detalles completos de todos los anuncios (incluyendo el público objetivo previsto, el público real, el gasto en anuncios y el comprador de anuncios) en su biblioteca de anuncios.

- Permitir una auditoría verificada por terceros independientes para que rindan cuentas de lo que dicen estar haciendo.

- Publicar su evaluación del riesgo preelectoral en Estados Unidos.

Pedimos a YouTube:

- Aumentar las capacidades de moderación de contenidos y los sistemas de integridad desplegados para mitigar el riesgo antes, durante y después de otras elecciones a nivel mundial, no sólo en Estados Unidos.

- Publicar información sobre qué medidas han tomado en cada país y cada idioma para garantizar la integridad de las elecciones.

- Incluir detalles completos de todos los anuncios (incluyendo el público objetivo previsto, el público real, el gasto en anuncios y el comprador de anuncios) en su biblioteca de anuncios.

- Permitir una auditoría verificada por terceros independientes para que rindan cuentas de lo que dicen estar haciendo.

- Publicar su evaluación de riesgo preelectoral para Estados Unidos.

Ciberseguridad para la Democracia es un esfuerzo independiente, no partidista y basado en la investigación para exponer las amenazas en línea a nuestro tejido social – y recomendar cómo contrarrestarlas. Formamos parte del Centro de Ciberseguridad de la Escuela de Ingeniería Tandon de la Universidad de Nueva York.

Respuesta de Meta:"Estos informes se basaron en una muestra muy pequeña de anuncios, y no son representativos dado el número de anuncios políticos que revisamos diariamente en todo el mundo. Nuestro proceso de revisión de anuncios tiene varias capas de análisis y detección, tanto antes como después de que un anuncio se publique. Invertimos importantes recursos para proteger las elecciones, desde nuestros esfuerzos de transparencia, líderes en el sector, hasta nuestra aplicación de estrictos protocolos en anuncios sobre temas sociales, elecciones o política, y seguiremos haciéndolo."